Van crawlbudget tot indexatie: zo bouw je met technische optimalisaties aan duurzame organische groei

Benieuwd hoe je duurzame organische groei realiseert? Ontdek hoe technische SEO – van crawlbudget en indexatie tot Core Web Vitals, mobile-first en JavaScript-rendering – het fundament legt waarop je content echt kan scoren. Met praktische stappen voor audits, prioritering en implementatie en oplossingen voor valkuilen als hreflang, facetnavigatie en migraties maak je je site sneller, duidelijker en beter indexeerbaar.

Wat is technische SEO

Technische SEO is de onzichtbare motor achter je vindbaarheid: alle optimalisaties die ervoor zorgen dat zoekmachines je site probleemloos kunnen crawlen, renderen en indexeren. Het gaat niet om teksten of copy, maar om de fundering waarop je content presteert. Denk aan een logische site-architectuur en schone URL-structuur, correcte canonicals om duplicate content te voorkomen, een robots.txt en XML-sitemap die je de juiste kant op sturen, en meta-robotsinstellingen die geen waardevolle pagina’s blokkeren. Snelheid en Core Web Vitals spelen een hoofdrol, net als mobile-first en de manier waarop JavaScript wordt gerenderd. Ook beveiliging met HTTPS, juiste redirects (301 in plaats van 302 waar nodig), en het oplossen van 4xx/5xx-fouten horen erbij.

Met structured data help je zoekmachines je content beter te begrijpen en in rich results te tonen, terwijl hreflang ervoor zorgt dat je de juiste taal- en regioversies serveert. Technische SEO optimalisatie begint vaak met een audit, gevolgd door het prioriteren en doorvoeren van verbeteringen die de grootste impact hebben. Zo leg je de basis waarop je content- en linkbuildinginspanningen echt kunnen scoren. Kort gezegd: als je je afvraagt wat is technische SEO, dan is het het geheel aan technische keuzes en fixes die jouw site snel, toegankelijk, begrijpelijk en betrouwbaar maken voor zowel gebruikers als zoekmachines (in het Duits ook wel technisches SEO genoemd).

Waarom het de basis is voor vindbaarheid

Zonder een sterke technische basis kan je content niet echt scoren, hoe goed die ook is. Als zoekmachines je site niet efficiënt kunnen crawlen, renderen en indexeren, verschijnen je pagina’s te laat, te laag of helemaal niet. Technische SEO zorgt dat je pagina’s snel laden, mobiel goed werken en zonder fouten bereikbaar zijn. Met een duidelijke site-architectuur en interne links help je robots de juiste weg te vinden, terwijl een XML-sitemap en een schone robots.

txt de deur op de juiste plekken openzetten. Canonicals en noindex beperken duplicate content, correcte statuscodes en redirects houden linkwaarde intact. Structured data vergroot je zichtbaarheid met rich results, en met HTTPS en hreflang bouw je vertrouwen én serveer je de juiste taalversie.

Het verschil met content-SEO

Technische SEO gaat over hoe je site werkt, content-SEO over wat je zegt. Met technische SEO zorg je dat zoekmachines je pagina’s snel kunnen crawlen, correct renderen en zonder fouten indexeren. Je richt je op zaken als laadsnelheid, Core Web Vitals, mobielvriendelijkheid, sitestructuur, canonicals, sitemaps en veilige HTTPS-verbindingen. Content-SEO draait om zoekintentie, trefwoorden, relevantie en autoriteit: de kwaliteit van je teksten, hoe volledig je onderwerpen behandelt en hoe je interne links je verhaal ondersteunen.

Zonder een solide technische basis krijgt je content niet de zichtbaarheid die het verdient, en zonder sterke content heeft een perfect geoptimaliseerde site weinig om te ranken. Het beste resultaat bereik je als techniek en content naadloos samenwerken.

[TIP] Tip: Maak een XML-sitemap en dien deze in bij Google Search Console.

De belangrijkste pijlers van technische SEO

Technische SEO rust op drie pijlers die bepalen of zoekmachines je site kunnen vinden, begrijpen en snel serveren. Zorg dat deze basis staat voordat je finetunet.

- Crawlbaarheid en indexatie: houd robots.txt schoon, bied een actuele XML-sitemap aan, zet correcte canonical-tags en gebruik noindex waar nodig om ruis/duplicaten te filteren; controleer ook statuscodes zodat alleen de juiste pagina’s indexeren.

- Snelheid en rendering: verbeter Core Web Vitals (LCP, INP, CLS) met slim cachen, beeldoptimalisatie en minder render-blocking resources; werk mobile-first (responsive templates, snelle hosting/CDN), serveer via HTTPS en zorg dat belangrijke content en links in HTML beschikbaar zijn met scripts zoveel mogelijk deferred/async.

- Site-architectuur en interne links: ontwerp een logische URL-structuur en platte hiërarchie, gebruik breadcrumbs en contextuele interne links om crawlpad en autoriteitsverdeling te optimaliseren; voorkom weespagina’s en houd navigatie voorspelbaar voor zowel gebruikers als bots.

Als deze pijlers kloppen, krijgt je content de beste kans om te presteren. Het maakt alle vervolgstappen in SEO effectiever en duurzamer.

Crawlbaarheid en indexatie (robots.txt, XML-sitemaps)

Crawlbaarheid en indexatie zijn twee stappen: eerst ontdekt een bot je URL’s, daarna worden ze beoordeeld en in de index gezet. Je stuurt crawling met een nette robots.txt: blokkeer ruis zoals admin- of zoekresultaat-URL’s, maar blokkeer nooit essentiële resources zoals CSS of JavaScript die nodig zijn voor rendering. Met een XML-sitemap geef je alleen canonieke, 200-status, https-URL’s door en houd je ze actueel met lastmod zodat nieuwe of gewijzigde pagina’s sneller worden opgepikt.

Gebruik noindex voor pagina’s die niet in de index horen en canonicals om varianten te bundelen. Normaliseer parameters om duplicaten te voorkomen. Check Search Console en je logbestanden om crawlbudget te sturen en blokkades, soft 404’s of omleidingslussen snel te vinden en te fixen.

Snelheid en rendering (core web vitals, mobile-first, javascript)

Snelheid en rendering bepalen hoe snel je pagina bruikbaar is en hoe goed zoekmachines je content kunnen verwerken. Core Web Vitals meten dat: LCP laat zien hoe snel het grootste element zichtbaar is, INP meet de respons op interacties en CLS bewaakt visuele stabiliteit. Je verbetert dit met een snelle server en lage TTFB, geoptimaliseerde afbeeldingen, compressie, caching, critical CSS, minder en uitgestelde JavaScript en slim lazy-loaden.

Door mobile-first indexing beoordeelt Google vooral je mobiele versie, dus zorg dat dezelfde content, links en structured data aanwezig zijn op mobiel. Gebruik bij JavaScript server-side rendering of prerendering, zet essentiële content en links in de initiële HTML en blokkeer bots niet voor JS en CSS. Monitor met field data en blijf itereren.

Site-architectuur en interne links

Een duidelijke site-architectuur zorgt dat je belangrijkste pagina’s met zo min mogelijk kliks bereikbaar zijn en dat zoekmachines je thema’s begrijpen. Werk met logische categorieën, korte, beschrijvende URL’s en consistente broodkruimels, zodat zowel gebruikers als bots de hiërarchie zien. Interne links verdelen autoriteit: gebruik relevante, natuurlijke anchor-teksten en link vanaf hub- of categoriepagina’s naar je beste content.

Zorg dat je geen weeskindpagina’s hebt en voorkom diepliggende content door een platte structuur met beperkte crawl depth. Let op pagination en canonicals bij lijsten, en houd navigatie, footer en contextuele links schoon en nuttig. Met een goede interne linking-strategie stuur je crawlers, versterk je topicale clusters en verhoog je de kans op hogere rankings.

[TIP] Tip: Optimaliseer snelheid, crawlbaarheid en indexering; herstel gebroken links en verkeerde redirects.

Technische SEO optimalisatie: van audit tot implementatie

Technische SEO optimalisatie begint met een grondige audit: crawl je site, combineer bevindingen uit Search Console en logbestanden, en breng indexatie, statuscodes, Core Web Vitals, rendering, canonicals, redirects, hreflang en structured data scherp in kaart. Daarna prioriteer je met een impact-versus-effortmatrix en koppel je de backlog aan je bedrijfsdoelen. Zet een duidelijke roadmap op, plan sprints met development en test elke wijziging eerst op staging met strikte QA. Gebruik feature flags en zorg voor rollbacks als iets performance of indexatie schaadt.

Valideer verbeteringen met field data van Core Web Vitals, Lighthouse, PageSpeed Insights en servermetriek zoals TTFB, en check of robots.txt, sitemaps en noindex-instellingen doen wat je wilt. Na livegang monitor je continu met dashboards en alerts, analyseer je crawlbudget en foutcodes, en voorkom je regressie bij releases. Documenteer keuzes, wijs eigenaars aan en evalueer periodiek. Zo maak je van technische SEO een doorlopend proces dat je zichtbaarheid en conversie meetbaar laat groeien.

Een audit uitvoeren (crawl, logbestanden, search console)

Deze vergelijking laat zien hoe crawl-tools, serverlogbestanden en Google Search Console elkaar aanvullen bij het uitvoeren van een technische SEO-audit: wat je meet, de sterke punten en de beperkingen per bron.

| Aanpak/bron | Wat je ontdekt | Sterktes | Beperkingen |

|---|---|---|---|

| Crawl (SEO spider, bijv. Screaming Frog/Sitebulb) | Statuscodes, broken links, redirectketens, meta robots/noindex, canonicals, hreflang, sitemap- en interne linkstructuur, JS-renderingproblemen. | Snel site-breed overzicht; reproduceerbaar; kan JS-rendering simuleren; goed voor patroon- en consistentiechecks. | Ziet alleen wat via links/sitemaps bereikbaar is; geen bewijs van echte botbezoeken; rendering hangt af van instellingen/toegang. |

| Serverlogbestanden (log-analyse) | Werkelijk crawlgedrag van Googlebot en andere bots, frequentie per URL, statuscodes die aan bots zijn geserveerd, verspild crawlbudget (parameters, 404’s, traps). | “Ground truth” van de server; onthult prioritering door bots; ideaal om crawlbudget te optimaliseren en problemen op te sporen die een crawler mist. | Toegang tot logs/CDN vereist; mogelijk sampling of geanonimiseerd; vraagt normalisatie en UA-validatie; geen content- of renderingdetails. |

| Google Search Console | Indexeringsstatus en redenen, URL-inspectie, sitemaps, Core Web Vitals (CrUX), rich results/structured data, crawlstatistieken, handmatige acties en beveiligingsissues. | Directe feedback van Google; inzicht in zichtbaarheid en prestaties; meldingen en trends; koppelt techniek aan impact op indexatie. | Alleen Google-data; vertraagd/gesampled; niet alle URL’s zichtbaar; beperkt inzicht in interne linkdiepte en redirectketens. |

Samen geven deze drie bronnen een compleet beeld: de crawl toont potentiële problemen, logbestanden tonen echt botgedrag, en Search Console laat Googles interpretatie en impact zien. Combineer ze om issues te prioriteren op SEO-impact versus implementatie-effort.

Een sterke technische audit begint met een volledige crawl van je site, inclusief JavaScript-rendering, zodat je statuscodes, canonicals, meta-robots, hreflang, structured data, interne links, URL-parameters, sitemaps en robots.txt in één beeld hebt. In je logbestanden zie je wat Googlebot echt doet: welke paden vaak gecrawld worden, waar crawlbudget weglekt naar filters of duplicaten, welke 3xx/4xx/5xx-fouten optreden, hoe diep bots komen en of de serverrespons stabiel is.

In Search Console valideer je dit met rapporten voor Pagina-indexering, Sitemaps, Core Web Vitals, Crawlstatistieken, Beveiligings- en handmatige acties en de URL-inspectie. Door bevindingen uit crawl, logs en Search Console te kruisen, ontdek je blokkades, prioriteer je fixes op impact en leg je een meetbare baseline voor je technische SEO-verbeteringen.

Prioriteren op impact en effort

Na je audit zet je alle bevindingen in een impact-versus-effortmatrix zodat je snel ziet welke acties het meeste resultaat opleveren voor de minste inspanning. Begin met quick wins die sitewide gelden, zoals het repareren van 404’s of het opschonen van sitemaps, en plan grotere trajecten zoals renderoptimalisatie of herstructurering van interne links als projecten met duidelijke mijlpalen. Koppel elk item aan een hypothese en KPI’s zoals indexatiegraad, Core Web Vitals en organisch verkeer, en weeg naast impact en effort ook risico, afhankelijkheden en doorlooptijd mee.

Gebruik een eenvoudige scoremethode (bijvoorbeeld ICE of RICE) en richt releases op templates en componenten voor maximale reikwijdte. Zo besteed je je ontwikkelcapaciteit aan de fixes die je zichtbaarheid aantoonbaar versnellen.

Implementeren, testen en monitoren

Na prioritering implementeer je eerst op een stagingomgeving die je zo dicht mogelijk bij productie houdt, zodat je technische SEO-wijzigingen realistisch kunt valideren. Automatiseer checks op statuscodes, canonicals, meta-robots, hreflang en structured data, en draai performance-tests met budgetten voor LCP, INP en CLS om regressies te voorkomen. Gebruik feature flags of een gefaseerde uitrol, monitor servermetrics zoals TTFB en errorrates, en voer visuele regressietests uit bij templatewijzigingen.

Na livegang ping je je XML-sitemaps, valideer je steekproeven met de URL-inspectie en controleer je logbestanden op crawlgedrag, 5xx-pieken en redirectketens. Richt alerts in voor Core Web Vitals, indexatieafwijkingen en 404’s, annoteer releases in dashboards en houd een rollback-plan paraat. Zo borg je dat elke change meetbaar verbetert en blijft presteren.

[TIP] Tip: Crawl wekelijks; los 404’s, canonical- en indexatiefouten direct op.

Speciale situaties en veelgemaakte fouten

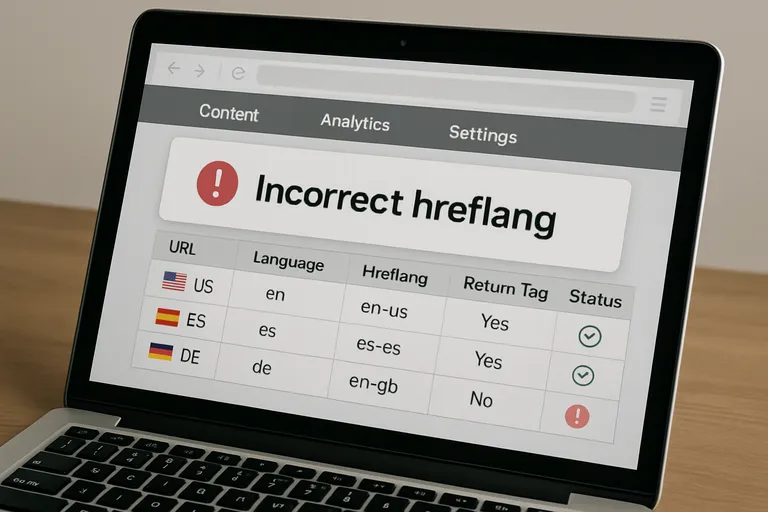

In speciale situaties komen technische SEO-valkuilen sneller naar boven. Bij meertalige of internationale sites gaat het vaak mis met hreflang: ongeldige combinaties, ontbrekende terugverwijzingen of conflicten met canonicals zorgen dat de verkeerde versie rankt. In e-commerce kunnen facetten en filters eindeloos veel URL-varianten creëren; zonder goede canonicals, noindex op ruis en strakke parametercontrole lek je crawlbudget en krijg je indexbloat. Bij JavaScript-rijke sites is server-side rendering of prerendering nodig, anders missen bots essentiële content of links. Migraties vragen om een waterdicht redirectplan met 301’s, consistente keuze voor http/https en www/non-www, en geen mixed content.

Let op pagination: voorkom dunne of duplicerende lijsten, bied waar mogelijk een “view-all” of canonicaliseer naar de eerste pagina. Veelgemaakte fouten zijn verder robots.txt die CSS/JS blokkeert, soft 404’s, redirectlussen, verouderde sitemaps, verkeerde noindex op belangrijke templates en misleidende structured data. Door vooraf te testen, na livegang nauwkeurig te monitoren en fouten snel te corrigeren, houd je controle over crawling en indexatie en blijft je fundament sterk, zodat je content en autoriteit daadwerkelijk kunnen renderen in duurzame organische groei.

Meertalige en internationale sites (HREFLANG, technisches SEO)

Bij meertalige en internationale sites draait het om de juiste versie aan de juiste gebruiker tonen. Met hreflang geef je per URL aan welke taal- en landvariant hoort bij die pagina; zorg voor geldige ISO-codes (bijv. nl-NL, fr-BE), wederkerige verwijzingen en dat hreflang naar de canonieke URL’s wijst. Voeg x-default toe voor je taalkiezer of generieke variant. Kies een consistente structuur (submappen, subdomeinen of ccTLD’s) en vermijd IP- of geolocatie-redirects; gebruik liever een zachte banner.

Stel eventueel geotargeting in Search Console in voor submappen of subdomeinen. Houd content en metadata per markt echt lokaal (valuta, units, spelling) om duplicatie te beperken. Dit is kernwerk in technische SEO én in technisches SEO voor DACH-markten.

E-commerce en facetnavigatie (filters)

Facetnavigatie is geweldig voor gebruikers, maar zonder strakke regels explodeert je aantal URL’s en verspil je crawlbudget. Bepaal eerst welke filtercombinaties zoekintentie vangen en maak daar indexeerbare landingspagina’s van met stabiele, leesbare URL’s, unieke titles en beschrijvende content; canonicaliseer deze naar zichzelf. Voor alle overige varianten houd je ze crawlbaar maar niet indexeerbaar met meta-robots noindex, zodat zoekmachines de signalen wel kunnen lezen; gebruik robots.

txt spaarzaam, want dan zien bots je noindex niet. Normaliseer parameters voor sorteren, prijs en beschikbaarheid naar de basiscategorie via canonicals en zorg voor nette paginering en consistente interne links. Voeg alleen waardevolle facetten toe aan je sitemap en monitor logbestanden op crawltraps en agressieve parametercombinaties. Zo behoud je controle én groei.

Veelvoorkomende valkuilen: duplicate content, redirects en mixed content

Duplicate content ontstaat als dezelfde pagina via meerdere URL’s bereikbaar is, bijvoorbeeld door parameters, sortering, hoofdletter-varianten, trailing slash, http/https, www/non-www of printerversies. Dwing één voorkeurs-URL af met 301-redirects, gebruik een zelfverwijzende canonical, houd interne links consistent en zet ruis op noindex; zorg ook dat hreflang naar de canonieke versie wijst. Bij redirects kies je 301 voor permanente wijzigingen, vermijd ketens en loops, update interne links en sitemaps en bewaak één domeinvariant en slash-conventie.

Mixed content breekt vertrouwen en kan indexatie hinderen: op https-pagina’s moet je alle assets via https laden, HSTS inschakelen en hardcoded http-links (ook in CDN’s) vervangen. Monitor met periodieke crawls, loganalyse en releasechecks om regressies te voorkomen.

Veelgestelde vragen over technische seo

Wat is het belangrijkste om te weten over technische seo?

Technische SEO zorgt dat zoekmachines je site kunnen crawlen, indexeren en renderen. Het vormt de basis onder vindbaarheid; zonder techniek presteert content-SEO niet. Denk aan snelheid/Core Web Vitals, mobile-first rendering, sitemaps/robots, canonicals en interne architectuur.

Hoe begin je het beste met technische seo?

Start met een audit: crawl de site, check Search Console, Core Web Vitals en logbestanden. Herstel blockers in robots.txt, XML-sitemap, statuscodes, redirects en canonicals. Prioriteer op impact/effort, implementeer via staging, test, monitor en herhaal.

Wat zijn veelgemaakte fouten bij technische seo?

Veelgemaakte fouten: per ongeluk blokkeren met robots/noindex, trage rendering door JavaScript, ketting-redirects, mixed content, soft 404’s, ontbrekende hreflang, ongecontroleerde facetfilters en duplicate content. Voorkom dit met canonicalisatie, parameterregels, server-side rendering waar nodig en continue monitoring.